1. Antecedentes

La Unión Europea (UE)[1] lleva años buscando una configuración adecuada para la responsabilidad civil de los sistemas inteligentes: (i) en 2017, se aprobó la Resolución del Parlamento Europeo (PE) con recomendaciones a la Comisión Europea (CE) sobre normas de Derecho civil sobre robótica[2]; (ii) en 2020, se publicaron el Libro Blanco sobre la Inteligencia Artificial[3] y el Informe de la CE al PE, al Consejo, y al Comité Económico y Social Europeo sobre seguridad y responsabilidad civil de la Inteligencia Artificial (IA), el internet de las cosas (IoT) y la robótica[4], y (iii) sumado a la reciente aprobación del Reglamento de Inteligencia Artificial (IA) cuyo texto se acordó a fines de 2023[5] y ha sido aprobado por el PE en 2024[6].

Recientemente, el trabajo co-legislativo de la UE ha dado importantes pasos, al impulsarse: (i) en 2020, una Resolución del PE y del Consejo con una propuesta de creación de un Reglamento que aborde la responsabilidad civil por el funcionamiento de los sistemas de IA de alto riesgo[7]; y (ii) en 2022 se impulsó por un lado una propuesta de Directiva del PE y del Consejo sobre adaptación de las normas de responsabilidad civil extracontractual para los sistemas de IA de alto riesgo[8], y por el otro, una propuesta de una nueva Directiva sobre responsabilidad por daños causados por productos defectuosos[9], que incluye el software y todos los demás sistemas de IA, actualizando el régimen creado en 1985 con la Directiva 85/374/CEE1 sobre responsabilidad por daños causados por productos defectuosos (en adelante, ambas serán conjuntamente referidas como las Directivas).

Ya desde la Resolución del PE de 2017 enfocada en robótica, el PE solicitó a la CE que propusiera instrumentos legislativos sobre los aspectos jurídicos relacionados con el desarrollo y el uso de la robótica y la IA, junto con instrumentos no legislativos —por ejemplo, directrices y códigos de conducta—[10], y que determinase si debiera aplicarse un enfoque de la responsabilidad objetiva o un enfoque de gestión de riesgos, entendiéndose que en el primero, únicamente se exige probar que se ha producido un daño o perjuicio y el establecimiento de un nexo causal entre el funcionamiento perjudicial del robot y los daños o perjuicios causados a la persona que los haya sufrido, mientras que en el enfoque de gestión de riesgos, el análisis no se centra en la persona “que actuó de manera negligente” como personalmente responsable, sino en la persona que es capaz, en determinadas circunstancias, de minimizar los riesgos y gestionar el impacto negativo.

Asimismo, se valoró ya en 2017 que una posible solución a la complejidad de la asignación de responsabilidad por los daños y perjuicios causados por robots cada vez más autónomos, podría ser el establecimiento de un régimen de seguro obligatorio, como ya se aplica, por ejemplo, en el caso de los automóviles, y que dicho sistema podría completarse con un fondo que garantizara la reparación de daños en los casos de ausencia de una cobertura de seguro[11].

2. Puntos sobresalientes de las Directivas

Las propuestas que impulsa la UE de dos nuevas Directivas[12] que actualicen, modernicen, clarifiquen y armonicen criterios de responsabilidad civil y seguridad[13] por productos defectuosos[14], regulando expresamente la responsabilidad extracontractual emergente por el uso de Sistemas de IA –recientemente regulados en el Reglamento de la IA de la UE[15]–, constituyen un relevante hito global en relación a cómo abordar las consecuencias civiles de sistemas complejos que pueden fallar (o ser atacados por terceros, y fallar por tal razón).

Este esfuerzo comunitario debe encastrarse con las normas nacionales ya en vigor en materia de responsabilidad civil en los 27 Estados Miembros, que generalmente se basan en la culpa, y por tanto pueden no ser adecuadas para acoger indemnizaciones por daños causados por productos y servicios en los que se utiliza la IA, dado que las víctimas deben demostrar que ha habido una acción u omisión ilícita por parte de una “persona” que ha causado el daño.

Las características específicas de la IA, incluidas su complejidad, su autonomía y su opacidad (el denominado efecto de “caja negra”), pueden dificultar o hacer excesivamente costoso para las víctimas determinar cuál es la persona responsable y probar que se cumplen los requisitos para una demanda de responsabilidad civil admisible[16].

Por otro lado, las estrategias nacionales de IA de varios Estados miembros están estudiando nuevas medidas legislativas sobre la responsabilidad civil en los casos en que medie IA y se espera que, si la UE no actúa a nivel supranacional, los Estados miembros adapten sus normas nacionales de responsabilidad civil a los retos que plantea la IA. Esto dará lugar a una mayor fragmentación y a un aumento de los costos para las empresas que operan en la UE[17].

Por ello el objetivo de las Directivas es promover la introducción generalizada de una IA fiable y confiable, a fin de aprovechar plenamente sus beneficios para el mercado interior, y a la vez garantizar que las víctimas de daños causados por la IA obtengan una protección equivalente a la de las víctimas de daños causados por los demás productos[18].

Es por eso que la CE adopta un enfoque holístico, proponiendo también ciertas adaptaciones a la responsabilidad civil del productor por productos defectuosos. Las dos iniciativas políticas están estrechamente vinculadas y forman un solo paquete: la Directiva sobre responsabilidad por los daños causados por productos defectuosos cubrirá la responsabilidad objetiva del productor por productos defectuosos, lo que da lugar a una indemnización por determinados tipos de daños, principalmente sufridos por particulares; mientas que la Directiva sobre responsabilidad extracontractual de la IA cubrirá principalmente la culpa de cualquier persona, con el fin de indemnizar por cualquier tipo de daño y a cualquier tipo de víctima[19].

La UE entiende que, en ausencia de normas comunitarias armonizadas para indemnizar los daños causados por los sistemas de IA, los proveedores, operadores y usuarios de sistemas de IA, por una parte, y, por otra, las personas perjudicadas, todos se verían confrontados a 27 regímenes de responsabilidad diferentes, lo que daría lugar a distintos niveles de protección y falsearía la competencia entre las empresas de los distintos Estados miembros. Es necesario reducir la fragmentación y otorgar una mayor seguridad jurídica con respecto a la exposición de las partes interesadas a la responsabilidad civil, garantizando un nivel (mínimo) de protección uniforme para todas las víctimas (particulares y empresas) e incentivos uniformes para prevenir daños y garantizar la rendición de cuentas[20].

En esta línea, la CE entiende que si bien los contenidos digitales, el software y los datos[21] desempeñan un papel crucial en el funcionamiento de muchos productos nuevos, aún no está claro hasta qué punto esos elementos intangibles pueden clasificarse como productos. Esto puede generar inseguridad jurídica sobre cómo se puede compensar a las partes perjudicadas por los daños causados por el software, incluidas las actualizaciones de software, y quién será responsable de dichos daños. La inclusión del software[22] y herramientas de IA dentro del régimen de productos defectuosos es deseable, y para ello es que se impulsa la modificación del régimen de productos defectuosos[23].

Además, las investigaciones de la CE mostraron que las nuevas tecnologías introducen nuevos riesgos, como la apertura a la entrada de datos que afectan la seguridad o los riesgos de ciberseguridad, mientras que la Directiva de productos defectuosos prevé compensaciones sólo por daños físicos o materiales[24].

En este contexto, algunas características específicas de la IA (por ejemplo, opacidad/falta de transparencia, explicabilidad, comportamiento autónomo, adaptación continua, previsibilidad limitada) hacen que sea particularmente difícil cumplir con la carga de la prueba para poder ganar una demanda de daños y perjuicios. Con arreglo a las normas de responsabilidad actuales, para reclamar una indemnización por daños y perjuicios, las víctimas suelen tener que probar la existencia del daño, una culpa del responsable y una causalidad entre esa culpa y el daño, o bien probar el daño, el defecto y la relación causal entre los dos[25].

Algunos sistemas de IA tienen características que hacen excesivamente difícil o incluso imposible que las víctimas identifiquen y prueben la culpa de una persona potencialmente responsable, o la existencia de un defecto y el vínculo causal entre esa culpa/defecto y el daño sufrido y, por tanto, se dificulta poder obtener una indemnización por los daños sufridos.

Estas particularidades propias de los sistemas actuales de responsabilidad civil crean un riesgo a nivel comunitario: que los 27 tribunales nacionales diverjan en sus enfoques, lo que podría llevar a una mayor fragmentación de las normas de responsabilidad por los daños causados por la IA en toda la UE. Esta fragmentación jurídica puede darse ya que los jueces tendrán que interpretar normas generales preexistentes que no fueron diseñadas teniendo en cuenta la IA para decidir pleitos de responsabilidad civil.

A lo anterior, se suma que la ley aplicable a una reclamo de responsabilidad civil en un contexto transfronterizo es, por defecto, la ley del país en el que se produce el daño, y dado que existen diferentes regímenes de responsabilidad, diferentes normas sobre onus probandi podrían aplicarse al mismo tipo de producto o servicio de IA desplegado en varios Estados miembros, aunque causen el mismo tipo de daño. Esto genera para las empresas una mayor inseguridad jurídica debido a normas de responsabilidad nacionales obsoletas y poco claras, pero también perjudica en potencia a las víctimas de daños causados por productos de IA, que tienen dificultades para obtener una indemnización justa en la UE. Esta diferencia de posibles indemnizaciones según dónde resida el ciudadano podría socavar la confianza de los ciudadanos en la IA, y también afectar la capacidad del sistema legal y judicial para garantizar resultados justos y equitativos en demandas relacionadas con sistemas de IA[26].

De allí que el fin de las Directivas sea que en la UE los eventuales perjudicados por los sistemas de IA disfruten del mismo nivel de protección que las personas perjudicadas por otras tecnologías. Para ello, se aligera la carga de la prueba de manera muy específica y proporcionada mediante el uso del deber de exhibición y las presunciones relativas (iuris tantum)[27]. Se establece la posibilidad de obtener información sobre los sistemas de IA de Alto Riesgo que deben registrarse, o documentarse de conformidad con el Reglamento de IA.

Por tal razón, la Directiva sobre responsabilidad por el uso de IA se aplicará respecto a las demandas civiles de responsabilidad extracontractual por daños y perjuicios causados por un sistema de IA, cuando dichas demandas se interpongan en el marco de regímenes de responsabilidad subjetiva (por culpa), es decir, conforme a los regímenes que establecen la responsabilidad legal de indemnizar los daños causados de forma deliberada o por un acto u omisión negligente y, más allá de las presunciones que crea, la Directiva no afecta a las normas nacionales o de la UE que determinan, por ejemplo, qué parte ha de soportar la carga de la prueba, qué grado de certeza es necesario para que haya fuerza probatoria o cómo se define la culpa[28], y tampoco afecta a las normas vigentes específicas de Ley de Servicios Digitales[29].

Ambas Directivas son parte de un conjunto más amplio de iniciativas, que incluyen el Reglamento de IA recientemente aprobado por el PE, pero también incluye la revisión de las Directivas sobre seguridad general de productos del año 2001[30], sobre productos elaborados del año 1984, y sobre maquinarias, ésta recientemente modificada por el Reglamento 2023/1230 de Junio de 2023, que armoniza los requisitos de salud y seguridad de las máquinas en los 27 Estados de la UE. También se impulsa una modificación a la Directiva (UE) 2020/1828, del 25 de noviembre de 2020, relativa a las acciones de representación para la protección de los intereses colectivos de los consumidores, de modo tal que se permitan class actions en la materia[31].

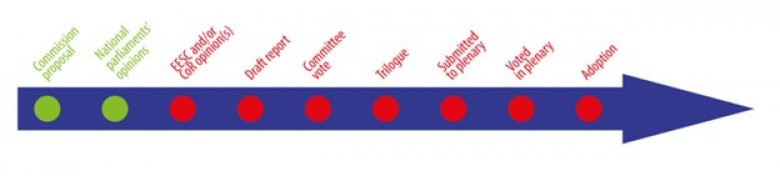

Es poco probable que las Directivas sobre responsabilidad civil extracontractual y responsabilidad por productos defectuosos que impulsa la UE sean aprobadas por el PE durante 2024, dados los pasos que aún deben transitarse[32].

La Directiva sobre responsabilidad civil extracontractual por uso de IA otorgaría a los tribunales nacionales el poder de ordenar la exhibición de evidencias sobre Sistemas de IA de Alto Riesgo sospechosos de haber causado daños. No obstante el buen timing legislativo de las Directrices propuestas, distintas partes interesadas y académicos han cuestionado la idoneidad y eficacia del régimen de responsabilidad propuesto, su coherencia con el Reglamento de IA aprobado por el PE el 13 de Marzo de 2024 con 523 votos a favor[33], y también alertado sobre su potencial impacto perjudicial sobre la innovación y la interacción entre las normas nacionales y de la UE[34].

3. Propuesta de Directiva de responsabilidad extracontractual por uso de IA:

El deber de diligencia y la inversión del onus probandi

Esta Directiva de responsabilidad por IA está compuesta por 8 Artículos, y pretende armonizar el derecho nacional de los 27 para que permitan reclamar una indemnización basada en la culpa consistente en el incumplimiento de un deber de diligencia impuesto por el Derecho de la Unión o el derecho nacional[35]. Asume que puede resultar difícil para los demandantes probar que existe un nexo causal entre dicho incumplimiento y la información de salida producida por el sistema de IA o la no producción de una información de salida por parte del sistema de IA que haya dado lugar a los daños en cuestión.

En su Art. 4 abajo transcripto se crea una presunción relativa de causalidad específica en relación con este nexo causal[36], bajo la creencia que esta presunción es la medida menos gravosa para dar respuesta a la necesidad de una indemnización justa para la víctima[37]. El actor debe demostrar la culpa del demandado con arreglo a las normas nacionales o de la Unión aplicables. Esta culpa puede determinarse por incumplir un deber de diligencia en virtud del Reglamento de IA, o de otras normas comunitarias, como las que regulan el uso de la supervisión y la toma de decisiones automatizadas para el trabajo en plataformas, o las que regulan el funcionamiento de aeronaves no tripuladas.

Ahora bien, en virtud del Art. 3 abajo transcripto, el Juez también puede presumir la culpa sobre la base del incumplimiento de una orden judicial de exhibición o conservación de pruebas[38]. No obstante, solo procede introducir una presunción de causalidad cuando pueda considerarse probable que la culpa en cuestión haya influido en la información de salida del sistema de IA pertinente —o en la ausencia de la información de salida—, lo cual puede evaluarse en función de las circunstancias generales del caso. Al mismo tiempo, el actor aún tiene que demostrar que el sistema de IA (es decir, su información de salida o la no producción de una información de salida) le ha causado los daños.

A su turno, el Art. 4 distingue entre demandas interpuestas contra el proveedor de un Sistema de IA de Alto Riesgo –o contra una persona sujeta a las obligaciones del proveedor en virtud del Reglamento de IA– y, por otra parte, las demandas interpuestas contra el usuario de dichos sistemas.

En el caso de los Sistemas de IA de Alto Riesgo (regulados en el Título III y en el Anexo III del Reglamento de IA), se establece una excepción a la presunción de causalidad cuando el demandado demuestre que el demandante puede acceder razonablemente a pruebas y conocimientos especializados suficientes para demostrar el nexo causal. Esta posibilidad busca incentivar a los demandados a cumplir sus obligaciones de exhibición y con las medidas establecidas por el Reglamento de IA para garantizar un alto nivel de transparencia de la IA, o el cumplimiento de los requisitos de documentación y registro[39].

En el caso de los Sistemas de IA de riesgo no elevado, se establece una condición para aplicar la presunción de causalidad: que el órgano jurisdiccional determine que es excesivamente difícil para el demandante demostrar el nexo causal[40]. Tales dificultades deben evaluarse a la luz de las características de ciertos sistemas de IA, como la autonomía y la opacidad, que hacen muy difícil en la práctica la explicación del funcionamiento interno del sistema de IA, lo que afecta la capacidad del actor para demostrar el nexo causal entre la culpa del demandado y la información de salida de IA[41].

En los casos en que el demandado utilice el sistema de IA en el transcurso de una actividad personal y no profesional, se establece que la presunción de causalidad solo debe aplicarse si el demandado ha interferido sustancialmente en las condiciones de funcionamiento del sistema de IA o si el demandado tenía la obligación y estaba en condiciones de determinar las condiciones de funcionamiento del sistema de IA y no lo hizo[42]. Esta condición se justifica por la necesidad de ponderar los intereses de los perjudicados y de los usuarios no profesionales, eximiendo de la aplicación de la presunción de causalidad aquellos casos en que los usuarios no profesionales no incrementen el riesgo a través de su comportamiento. Por último, el Art. 4, apartado 7, establece que el demandado tiene derecho a refutar la presunción de causalidad basada en el Art. 4, apartado 1[43].

CONTINUAR LEYENDO

Citas

(*) Sebastián Heredia Querro es Abogado (UCC), Magíster en Derecho Empresario (U. Austral) y Magíster en Finanzas (ESADE). Es co-fundador de Wootic, una software factory boutique enfocada en DLTs y machine learning.

[1] Confr. DÍEZ ROYO, Mario, “Cuestiones de responsabilidad civil de los sistemas de Inteligencia Artificial en las Propuestas de Directivas europeas de 28 de septiembre de 2022”, Revista de Estudios Jurídicos y Criminológicos, n.º 8, Universidad de Cádiz, 2023, pp. 253-276, DOI: https://doi. org/10.25267/REJUCRIM.2023.i8.09.

[2] Confr. https://www.europarl.europa.eu/doceo/document/TA-8-2017-0051_ES.html

[3] Confr. https://commission.europa.eu/document/download/d2ec4039-c5be-423a-81ef-b9e44e79825b_es?filename= commission-white-paper-artificial-intelligence-feb2020_es.pdf

[4] Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52020DC0064

[5] Confr. Heredia Querro, Sebastián, Apuntes sobre el nuevo Reglamento de Inteligencia Artificial de la Unión Europea (Diciembre 29, 2023). La Ley, AÑO LXXXVII Nº 244, 2023, disponible la 04/04/24 en: https://ssrn.com/abstract=4692238

[6] Confr. https://www.europarl.europa.eu/news/es/press-room/20240308IPR19015/la-eurocamara-aprueba-una-ley-historica- para-regular-la-inteligencia-artificial

[7] Véase infra nota 86. Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52020IP0276&from=EL. En esta Resolución se propone aplicar un régimen de responsabilidad objetiva para todos los sistemas de IA de alto riesgo, que son los regulados por el Título III y descriptos en el Anexo III del Reglamento de Inteligencia Artificial, véase o.c. nota 6. A los sistemas de IA que no sean considerados de alto riesgo, se les propone aplicar un régimen de responsabilidad subjetiva, pero en la propuesta de Directiva de 2022 (primer borrador de la CE), se optó por introducir una presunción relativa de causalidad en contra del proveedor del sistema de IA. En ambos casos, el proveedor de un sistema de IA sólo se liberará probando la fuerza mayor.

[8] Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52022PC0496. Esta Directiva, afirma DÍEZ ROYO, Mario, “Cuestiones de responsabilidad..” o.c., p. 261 aborda una de las mayores dificultades de toda responsabilidad que involucra a sistemas de IA: la prueba del nexo causal, y lo hace mediante la aplicación de la presunción de la relación

de causalidad. El objeto de dicha presunción es proteger al perjudicado en aquellos casos en los que sea complicado demostrar el nexo causal. La Directiva invierte la carga de la prueba y además crea obligaciones de exhibición de pruebas y documentos cuando se trata de Sistemas de IA de Alto Riesgo (según la definición de éstos del Reglamento de IA). Se critica que el plantear una responsabilidad subjetiva para los daños generados por los sistemas de IA que no sean de alto riesgo, se generan problemas con la aplicación de la responsabilidad objetiva por los daños causados, en general, por productos defectuosos, y es posible que si ambos textos –la propuesta de Directiva sobre productos defectuosos del PE y del Consejo y la propuesta de Directiva sobre responsabilidad civil extracontractual por uso de sistemas de IA– entran en vigor, puedan quizás producirse algunas contradicciones, puesto que en ambos casos se trata de productos que pueden funcionar mal y causar daños por tal razón. Confr. DÍEZ ROYO, Mario, “Cuestiones de responsabilidad..” o.c., p. 265.

[9] Confr. https://eur-lex.europa.eu/resource.html?uri=cellar:b9a6a6fe-3ff4-11ed-92ed-01aa75ed71a1.0015.02/DOC_1&format=PDF

Esta propuesta de Directiva actualizará normativa vigente desde 1985, introduciendo el software y sistemas de IA dentro de la definición de “producto”. Afirma DÍEZ ROYO, Mario, “Cuestiones de responsabilidad civil de los …”, o.c. p. 260 que cuando los sistemas de IA son calificados como productos, si actúan de una forma defectuosa y generan un daño, los dañados deberán ser resarcidos por el fabricante responsable. Los sujetos dañados no necesitan demostrar la culpa del fabricante, sino que sólo necesitan demostrar el defecto de un producto. Y no solo se consideran responsables por sus productos defectuosos los fabricantes de equipos informáticos, sino también los proveedores de programas informáticos y servicios digitales.

[10] Confr. https://www.europarl.europa.eu/doceo/document/TA-8-2017-0051_ES.html considerando 49 y ss.

[11] En esta línea, el PE solicitó a la CE que explore cómo opciones: (i) establecer un seguro obligatorio en el que los fabricantes o los propietarios de robots estarían obligados a suscribir un contrato de seguro por los posibles daños y perjuicios causados por sus robots; (ii) establecer un fondo de compensación que garantice la reparación de los daños o perjuicios causados por un robot ante la ausencia de un seguro; (iii) permitir que el fabricante, el programador, el propietario o el usuario puedan beneficiarse de un régimen de responsabilidad limitada si contribuyen a tal fondo de compensación, o bien si suscriben conjuntamente un seguro que garantice la compensación de daños o perjuicios causados por un robot; o (iv) crear a largo plazo una personalidad jurídica específica para los robots, de forma que los robots autónomos más complejos puedan ser considerados personas electrónicas responsables de reparar los daños que puedan causar, y posiblemente aplicar la personalidad electrónica a aquellos supuestos en los que los robots tomen decisiones autónomas inteligentes o interactúen con terceros de forma independiente

[12] Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52022PC0496, primer borrador de Directiva sobre responsabilidad extracontractual para la IA, y primer borrador de Directiva de responsabilidad contractual por productos defectuosos, incluyendo IA, de Septiembre de 2022: https://single-market-economy.ec.europa.eu/document/download/3193da9a-cecb-44ad-9a9c-7b6b23220bcd_en?filename=COM_2022_495_1_EN_ACT_part1_v6.pdf&prefLang=es. Ampliar en https://www.europarl.europa.eu/topics/es/article/20231023STO08103/mejor-proteccion-del-consumidor-normas-de-la-ue-sobre-productos-defectuosos.

[13] La seguridad general de productos comercializados en la UE está regulada hace 20 años en la actual Directiva 2001/95/CE -en proceso de revisión- relativa a la seguridad general de los productos (DSGP), disponible aquí: https://eur-lex.europa.eu/ES/legal-content/summary/product-safety-general-rules.html

[14] La actual regulación comunitaria sobre responsabilidad civil por productos defectuosos es del año 1985. Disponible aquí: https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:31985L0374. Casi 40 años atrás, la Directiva sobre responsabilidad por los daños causados por productos defectuosos (Directiva 85/374/CEE) armonizó la responsabilidad civil de los fabricantes de productos defectuosos con los regímenes nacionales no armonizados. La Directiva proporciona un nivel de protección que no garantizan por sí solos los regímenes nacionales de responsabilidad subjetiva, e introdujo un sistema de responsabilidad civil objetiva del productor por los daños causados por los defectos de sus productos. En caso de daño material o físico, la parte perjudicada tiene derecho a indemnización si puede probar el daño, el defecto del producto (es decir, que no ofrecía la seguridad que el público tiene derecho a esperar) y el nexo causal entre el producto defectuoso y el daño. Los regímenes nacionales no armonizados tienen normas en materia de responsabilidad civil subjetiva, según las cuales las víctimas de daños deben probar la culpa de la persona responsable, el daño y la causalidad entre la culpa y el daño, para tener derecho a indemnización. También contemplan regímenes de responsabilidad objetiva, en los que el legislador nacional ha atribuido la responsabilidad civil por un riesgo a una persona concreta, sin necesidad de que la víctima pruebe la existencia de culpa o defecto o de causalidad entre la culpa o el defecto y el daño. Los regímenes nacionales de responsabilidad civil proporcionan a las víctimas de daños causados por productos y servicios varias acciones indemnizatorias paralelas, basadas en la culpa o en la responsabilidad objetiva. Estas acciones se dirigen a menudo contra distintas personas responsables y se rigen por condiciones diferentes.

Ahora bien, se afirma que las características de las tecnologías digitales emergentes, como la IA, el internet de las cosas y la robótica, ameritan repensar ciertos aspectos de los marcos de responsabilidad civil nacionales y de la Unión. Algunas de las características de los sistemas actuales de responsabilidad pueden dificultar la determinación de la relación causal entre los daños y un comportamiento humano, uno de los elementos esenciales y necesarios para presentar una reclamación por responsabilidad subjetiva, de conformidad con las normas nacionales. Esto significa que, en las reclamaciones basadas en las normativas nacionales de responsabilidad civil subjetiva, la cuestión probatoria puede ser gravosa o excesivamente onerosa y, por lo tanto, es posible que las víctimas no reciban una compensación adecuada. Es importante que las víctimas de accidentes ocasionados por productos y servicios basados en tecnologías digitales emergentes, como la IA, no gocen de un nivel de protección inferior al que tienen respecto de otros productos y servicios similares, por los que recibirían una indemnización conforme a la normativa nacional de responsabilidad civil, porque podría disminuir la aceptación social de estas tecnologías emergentes y generar vacilación en cuanto a su uso. Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52020DC0064, p. 15.

[15] Confr. Heredia Querro, Sebastián, Apuntes sobre el nuevo Reglamento de Inteligencia Artificial de la Unión Europea (December 29, 2023). La Ley, AÑO LXXXVII Nº 244, 2023, disponible la 04/04/24 en: https://ssrn.com/abstract=4692238

[16] Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52022PC0496, primer borrador de Septiembre de 2022, p. 1.

[17] Idem, p. 2.

[18] Ibid.

[19] Idem, p. 4.

[20] Idem, p. 7.

[21] Véase el Reglamento para la Gobernanza de Datos, DGA, en Heredia Querro, Sebastián, Hacia un mercado europeo de datos: el nuevo régimen de los intermediarios (neutrales) de datos, publicado el 15/01/2024 en https://abogados.com.ar/hacia-un-mercado-europeo-de-datos-el-nuevo-regimen-de-los-intermediarios-neutrales-de-datos/34073.

[22] Confr. Considerando 13, https://single-market-economy.ec.europa.eu/document/download/3193da9a-cecb-44ad-9a9c-7b6b23220bcd_en?filename=COM_2022_495_1_EN_ACT_part1_v6.pdf&prefLang=es. Nótese que el software open source o de código abierto quedará excluido de la aplicación de esta Directiva para no obstaculizar la innovación o la investigación. La Directiva no debe aplicarse al software libre y de código abierto desarrollado o suministrado fuera del curso de una actividad comercial. Este es en particular el caso del software, incluido su código fuente y sus versiones modificadas, que se comparte abiertamente y es de libre acceso, utilizable, modificable y redistribuible. Sin embargo, cuando el software se suministra a cambio de un precio o los datos personales se utilizan de forma distinta a la de mejorar la seguridad, la compatibilidad o la interoperabilidad del software y, por tanto, se suministra en el curso de una actividad comercial, debe aplicarse la Directiva.

[23] Confr. https://ec.europa.eu/commission/presscorner/detail/es/ip_22_5807. En efecto, la propuesta de nueva Directiva para responsabilidad por productos defectuosos afirma que con respecto a la IA en particular, los sistemas de IA y los bienes habilitados para IA son "productos" y, por lo tanto, entran dentro de su ámbito de aplicación, lo que significa que se puede obtener compensación cuando una IA defectuosa causa daños, sin que la persona perjudicada tenga que demostrar la responsabilidad del fabricante, como ocurre con cualquier otro producto. En segundo lugar, la propuesta deja claro que no sólo los fabricantes de hardware, sino también los proveedores de software y los proveedores de servicios digitales que afectan el funcionamiento del producto (como un servicio de navegación en un vehículo autónomo) pueden ser considerados responsables. En tercer lugar, la propuesta garantiza que los fabricantes puedan ser considerados responsables de los cambios que realicen en los productos que ya han comercializado, incluso cuando esos cambios sean provocados por actualizaciones de software o aprendizaje automático. En cuarto lugar, la directiva alivia la carga de la prueba en casos complejos, que podrían incluir ciertos casos que involucran sistemas de inteligencia artificial, y cuando los productos no cumplen con los requisitos de seguridad. Como complemento a estos cambios, la propuesta paralela de Directiva sobre la responsabilidad por culpa de la IA pretende aliviar la carga de la prueba si se cumplen ciertas condiciones.

[24] Confr. Artificial intelligence liability directive, Overview, disponible al 04/04/24 en https://www.europarl.europa.eu/RegData/etudes/BRIE/2023/739342/EPRS_BRI(2023)739342_EN.pdf. La nueva definición de “daños” prevista en la Directiva de responsabilidad por productos defectuosos (Art. 4(6)) contempla el deber de indemnizar pérdidas materiales que resulten de: (a) muerte o lesiones personales, incluido el daño médicamente reconocido a la salud psicológica; (b) daño o destrucción de cualquier propiedad, excepto: (i) el propio producto defectuoso; (ii) un producto dañado por un componente defectuoso de ese producto; (iii) bienes utilizados exclusivamente para fines profesionales; y

(c) pérdida o corrupción de datos que no se utilicen exclusivamente para fines profesionales.

[25] Ibid.

[26] Ibid.

[27] Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52022PC0496, primer borrador de Septiembre de 2022, p. 13.

[28] Ibid.

[29] Para un análisis profundo de la Digital Services Act (DSA) y la Digital Markets Act (DMA) de la Unión Europea, véase Heredia Querro, Sebastián, Breve introducción al régimen europeo de Mercados y Servicios Digitales, 15/02/24, disponible al 04/04/24 en https://abogados.com.ar/breve-introduccion-al-regimen-europeo-de-mercados-y-servicios-digitales/34263

[30] Confr. https://www.ccoo.es/ab6568053b5c7bc5c44f48cd47bebb4d000001.pdf

[31] Véase Art. 6 de la Directiva sobre adaptación de las normas de responsabilidad civil extracontractual a la IA, o

Directiva sobre responsabilidad en materia de IA.

[32] El Comité Económico y Social Europeo emitió su dictamen en Octubre de 2021 (disponible aquí: https://www.ccoo.es/ab6568053b5c7bc5c44f48cd47bebb4d000001.pdf). El borrador de Directiva sobre adaptación de las normas de responsabilidad civil extracontractual a la IA que propone la CE es el que se analiza en el presente artículo, y ha sido asignado al Comité de Asuntos Legales (JURI). Durante 2024, el Parlamento y el Consejo de la Unión deberán considerar y adoptar el texto propuesto por la CE, en un proceso conocido como el triálogo CE-PE-Consejo, luego de lo cual la versión definitiva será tratada por el PE para su aprobación en el plenario.

[33] Confr. https://www.europarl.europa.eu/news/en/press-room/20240308IPR19015/artificial-intelligence-act-meps-adopt-landmark-law

[34] Confr. https://www.europarl.europa.eu/RegData/etudes/BRIE/2023/739342/EPRS_BRI(2023)739342_EN.pdf

[35] Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52022PC0496, primer borrador de Septiembre de 2022, p. 15.

[36] Véase Art. 4, apartado 1.

[37] Confr. https://eur-lex.europa.eu/legal-content/ES/TXT/PDF/?uri=CELEX:52022PC0496, primer borrador de Septiembre de 2022, p. 15.

[38] Art. 3, apartado 5.

[39] Idem, p. 16.

[40] Véase Art. 4, apartado 5.

[41] Ibid.

[42] Véase Art. 4, apartado 6.

[43] Ibid.

Opinión

Estudio Garrido Abogados

opinión

ver todosResqui Pizarro-Recasens Siches & Asociados

Kabas & Martorell

Ce Barrero